telegeram中文版官网下载

tokenizer分词_tokenizer分词器怎么部署到线上

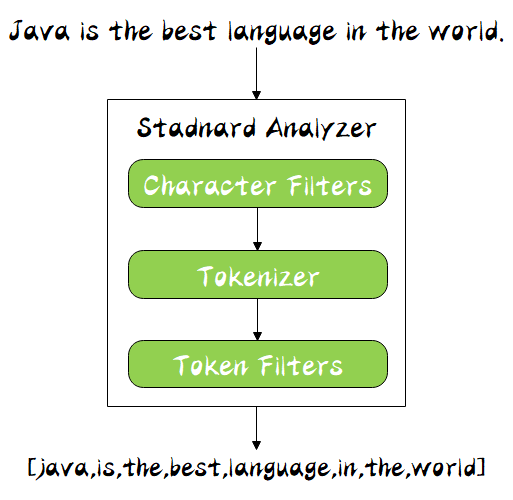

这些算法称为 Tokenizer分词器 , 这些Token会被进一步处理, 比如转成小写等, 这些处理算法被称为 Token Filter词元处理器 ,被。

其中 token 为分词结果 start_offset 为起始偏移 end_offset 为结束偏移 position 为分词位置下面来看下 Simple Analyzer 分词器它只包括了 Lower Case 的 Tokenizer ,它会按照 非字母切分 , 非。

ltfieldType name=quottextquot class=quotsolrTextFieldquotltanalyzerlttokenizer class=quotsolrStandardTokenizerFactoryquotltanalyzerltfieldType元素的类名称不是一个真实的分词器,但是它指向一个实现了。

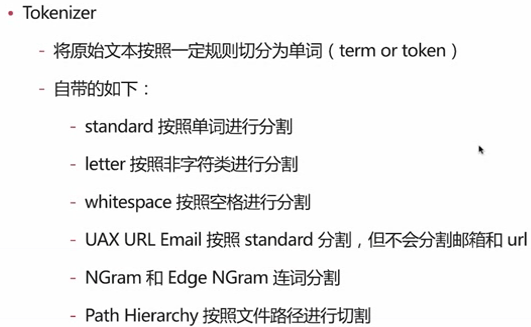

Elasticsearch全文检索默认分词器为standard analyzerstandard analyzer中,character Filter什么也没有做,Token Filters只是把英文大写转化为小写,因此Elasticsearch默认对大小写不敏感,下面主要介绍Tokenizer token分隔符把text。

HCT也是一个通用的中文分词工具HCT全称为HanLP Common Tokenizer,是由一套基础分词算法组成的通用中文分词工具高效采用Java8函数式编程风格实现,多核支持,秒级别性能精准中文分词采用bigram隐马模型,实体名词识别。

5 jieblcut 以及 jiebalcut_for_search 直接返回list 6 jiebaTokenizerdictionary=DEFUALT_DICT 新建自定义分词器,可用于同时使用不同字典,jiebadt为默认分词器,所有全局分词相关函数都是该分词器的映射。

character filtertokenizertoken filters 官网example通常为了保证索引时覆盖度和搜索时准确度,索引分词器采用ik_max_word,搜索分析器采用ik_smart模式 因为倒排索引中的数据是索引时由分词器来处理的,如果分词器有。

1ngram分词器Elasticsearch实现模糊搜索 2keyword忽略大小写 Controller Service 大小写兼容搜索,即字段内容为 alan ,搜索 alan ALAN Alan 都可以搜索出来根据 min_gram 以及 max_gram 指定切分时最小几个字符。

到此为止一个新的类型的分词器就定义好了,接下来就是要如何使用了或者按如下配置curl XPUT localhost9200indexname d #39 quotsettingsquot quotanalysisquot quotanalyzerquot quotikquot quottokenizerquot quotikquot 。

它使用一个名为“ngram_tokenizer”的Ngram分词器可以用如下语句测试charSplit分析器,可以看到一字一词的效果curl POST。

然后再匹配一次,又会提示Italy这就是Multi的由来支持多个单词的提示,当然必须设置正确的分词方式Tokenizer解决办法就是通过setThresh来设置至少输入几个字符后才会有提示 这样输入一个字符的时候就会开始提示。

List不定长,可以暂时用来保存数据全部词元处理完之后可以进行转化List和数组可以很方便的相互转化public class TokenizerApp public static String encodeString routeStr String firstLetter = quotquotString resultStr。

如果你指的用指定字符串分割原字符串,可用下面的 split 自定义函数include ltiostream#include ltstring#include ltalgorithm#include ltsstream#include ltvectorusing namespace stdvectorltstring splitconst string。

solr中string和text的区别如下1string类型的字段一般用于精确匹配,区分大小写而text则是模糊匹配,而且可以二次处理如上面的配置里面的分词,小写和去除重复lttokenizer class=quot。

下面需要在solr的schemalxml进行分词器注册lt! 配置IK分词器 ltfieldType name=quottext_ikquot class=quotsolrTextFieldquot positionIncrementGap=quot100quot ltanalyzer type=quotindexquot lt! 分词 lttokenizer class=quot。

“Italy,It”,那么此时MultiAutoCompleteTextView根据你设置的分词方式CommaTokenizer,分解出 quotItquot,然后再匹配一次, 又会提示Italy这就是Multi的由来支持多个单词的提示,当然必须设置正确的分词方式Tokenizer。

相关文章

发表评论

评论列表

- 这篇文章还没有收到评论,赶紧来抢沙发吧~