您现在的位置是:首页 > telegeram安卓下载 > 正文

telegeram安卓下载

tokenembedding_tokenembedding的作用

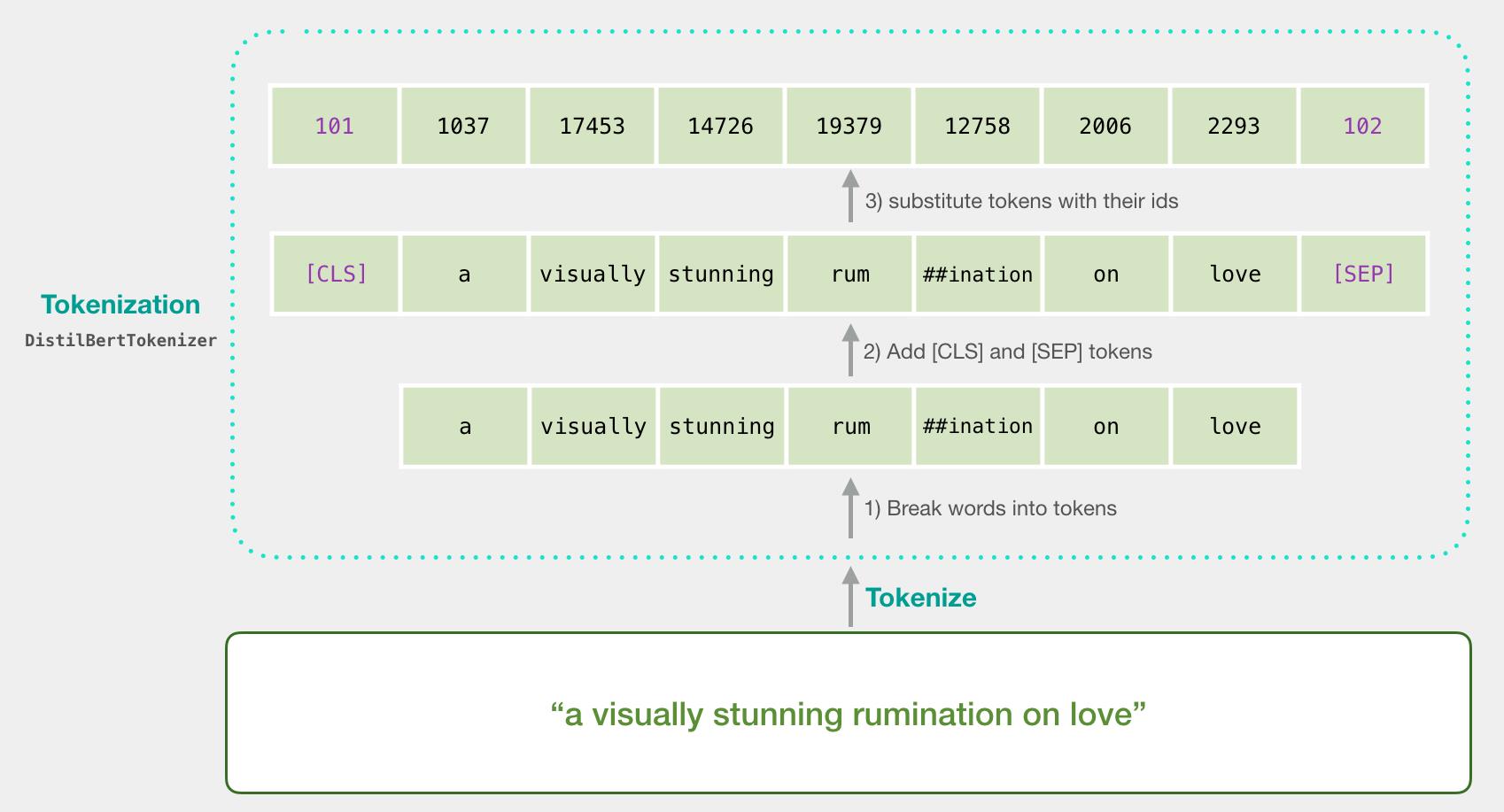

TokenEmbedding就是正常的词向量,即PyTorch中的nnEmbeddingSegmentEmbedding的作用是用embedding的信息让模型分开上下句,我们

Token Embedding 就是正常的词向量,即 PyTorch 中的 nnEmbedding Segment Embedding 的作用是用 embedding 的信息让模型 分开上下句 ,我们给上句的 token 全 0,下句的 token 全 1,让模型得以判断上下句的起止位置,例如 Positio。

两个不同方向的LSTM模型是互不干扰的,他们的联系就只有输入的token的embedding是共用的,以及最后的全连接加softmax是通用的。

如下图所示,我们定义输入的embedding为 ,BERT最终输出的 CLS 的embedding为 ,最终输出的第 个token的embedding为 我们有理由相信一个深度双向模型比lefttoright模型和lefttoright和righttoleft简单连接的模型的效果更加强大。

引入Position Embedding主要是为了弥补Transformer模型对位置信息的不足,将Position Embedding与token Embedding相加后,即可保留各个token的位置信息论文作者提出了两种添加位置信息的的方法 一种方法是直接用不同频率的正余弦。

相关文章

发表评论

评论列表

- 这篇文章还没有收到评论,赶紧来抢沙发吧~